- Мониторы 144 Гц

- Мониторы 240 Гц

- Мониторы 360 Гц

- Игровые Ultrawide

- Игровые изогнутые мониторы

- Мониторы с NVIDIA G-SYNC

- Мониторы Type-C

- Игровые OLED-мониторы

- Большие мониторы

- Профессиональные портативные

- Мониторы Apple

- Мониторы Type-C

- Мониторы OLED

- Игровые телевизоры

- Телевизоры 4К

- Телевизоры OLED

- Телевизоры HDR

- Телевизоры 8К

- Acer

- AOC

- AOpen

- Apple

- ASRock

- ASUS

- BenQ

- Cooler Master

- Corsair

- DELL

- DIGMA

- DIGMA PRO

- Eizo

- Gigabyte

- GMNG

- HP

- HUAWEI

- iiyama

- Lenovo

- LG

- MSI

- NEC

- NPC

- Philips

- Razer

- Samsung

- Sharp

- Sony

- TCL

- TCL

- Titan Army

- Viewsonic

- Xiaomi

- Для дизайнера

- Офисные мониторы

- Универсальные мониторы

- Доставка

- Обмен и возврат

- Новости

- Оплата частями

- Как сделать заказ

- Кронштейны

- Мыши

- Клавиатуры

- Наушники и гарнитуры

- Очки для монитора

- Игровые консоли

- Освещение для монитора

- Кабели для мониторов

- Сетевые фильтры

- Чистящие средства

- Измерительные устройства

- Коврики для мыши

- Acer

- AOC

- AOpen

- Apple

- ASRock

- ASUS

- BenQ

- Cooler Master

- Corsair

- DELL

- DIGMA

- DIGMA PRO

- Eizo

- Gigabyte

- GMNG

- HP

- HUAWEI

- iiyama

- Lenovo

- LG

- MSI

- NEC

- NPC

- Philips

- Razer

- Samsung

- Sharp

- Sony

- TCL

- TCL

- Titan Army

- Viewsonic

- Xiaomi

- Все товары

- Для дизайнера

- Игровые Телевизоры

- Офисные мониторы

- Универсальные мониторы

- Уценка

HDR в современных мониторах

HDR в современных мониторах: технологии, стандарты и реальность

Введение

HDR (High Dynamic Range) — технология, направленная на более точную передачу светлых и тёмных деталей изображения. Это не просто “ярче” или “цветастее” — цель HDR заключается в том, чтобы приблизить изображение к тому, как его воспринимает человеческий глаз, и как его задумывал создатель контента, будь то режиссёр фильма или дизайнер видеоигры.

На практике HDR в мониторах включает в себя три ключевых компонента:

-

Глубина цвета — количество оттенков, которые способен отобразить дисплей. Например, 10-битная глубина цвета позволяет отображать более миллиарда цветов и плавные градиенты без полос;

-

Расширенный цветовой охват — способность воспроизводить более насыщенные и разнообразные цвета, выходящие за пределы стандартного цветового пространства sRGB/Rec.709. HDR как стандарт не увеличивает цветовой охват сам по себе, но использует полноценно его, если это позволяет панель монитора;

-

Высокий динамический диапазон в буквальном смысле — это разница между самыми яркими и самыми тёмными участками изображения, которые может отобразить экран без потери деталей. Это ключевой параметр, определяющий выразительность HDR-контента.

HDR становится особенно заметным в фильмах и играх, где важны визуальные эффекты и атмосфера, а также в некоторых областях профессиональной работы с изображением и видео, где нужно точно видеть результат, предназначенный для отображения на HDR-устройствах. Однако для большей части повседневной офисной и даже профессиональной работы (дизайн полиграфии, кодинг, фото в sRGB) HDR остаётся избыточным.

Почему HDR стал актуальным в современных дисплеях?

Появление доступных по цене HDR-мониторов, массовое распространение HDR-контента (стриминг, YouTube, игры на консолях и ПК), а также прогресс в технологиях панелей и подсветки сделали HDR не просто модным словом, а характеристикой современных дисплеев.

Цель этой статьи — разобраться, что стоит за надписью HDR на коробке монитора. Какие технологии и стандарты используются, каковы реальные возможности современных панелей, и в чём заключается разрыв между маркетингом и реальностью.

Часть 1. Основы технологии HDR

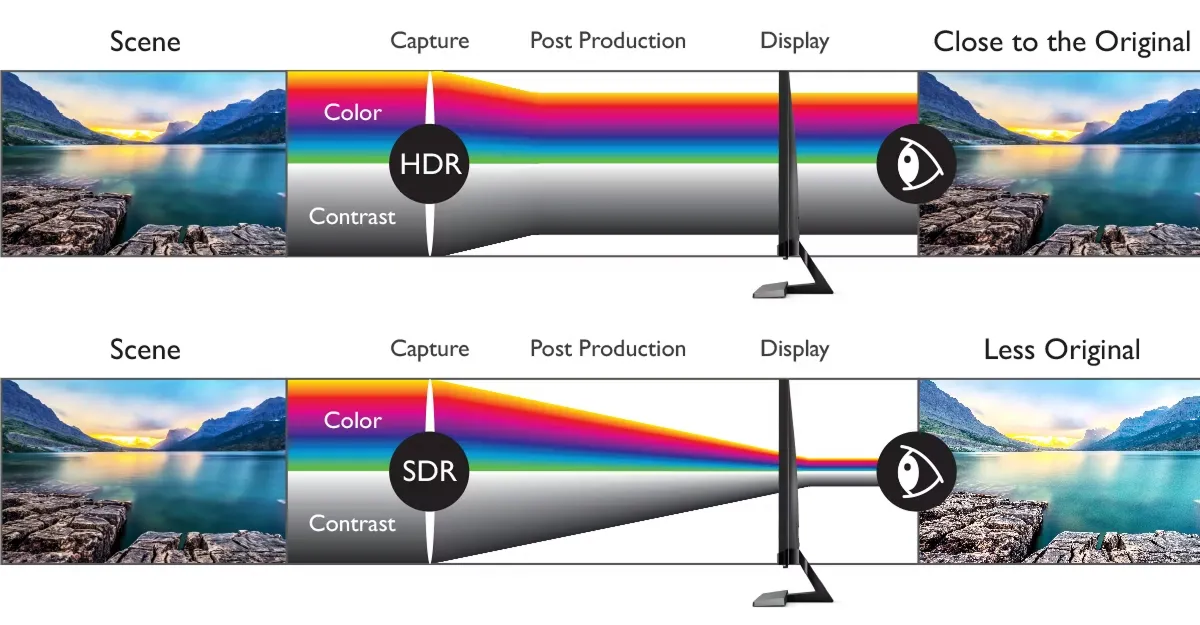

SDR против HDR: стандартное изображение против расширенного динамического диапазона

Технология HDR (High Dynamic Range) противопоставляется традиционному SDR (Standard Dynamic Range), который определяет возможности вывода изображения, ограниченные яркостью, цветовым охватом и глубиной цвета. SDR базируется на стандартах, принятых ещё во времена кинескопов — в первую очередь Rec.709 (совпадает с цветовым пространством sRGB) и 8-битной глубине цвета.

HDR (High Dynamic Range) — это развитие этих стандартов, направленное на более реалистичную передачу изображения. Но важно понимать: HDR — это не конкретный стандарт, а совокупность технологий, включающая в себя работу с цветом, яркостью и контрастом.

Теоретические преимущества HDR

Глубина цвета: 8 бит vs 10/12 бит

Стандарт SDR традиционно использует 8-битную глубину цвета на канал (итого ~16.7 млн цветов). Однако возможность передачи 10-битного сигнала в SDR существует уже давно — более 15 лет, особенно в профессиональной сфере (например, в видеомонтаже, работе с фото и графикой в AdobeRGB и т. п.).

Тем не менее, HDR требует минимум 10 бит для полноценной передачи тонких градаций яркости и плавных переходов. Это помогает избежать эффекта постеризации — резких полос на градиентах, особенно заметных в небе или тенях.

-

8 бит → 256 градаций на канал

-

10 бит → 1024 градации

-

12 бит → 4096 градаций

Чем выше битность, тем точнее можно отобразить световые переходы и полутона — особенно важные для HDR.

Цветовой охват: от Rec.709 к Rec.2020

Хотя SDR чаще всего используют в пространстве Rec.709 (он же sRGB) — это лишь стандарт для массовых дисплеев, интернета и ТВ. На самом деле, SDR может работать и в более широких цветовых пространствах, таких как AdobeRGB или DCI-P3, особенно при 10–12-битной глубине цвета. Поэтому SDR не обязательно ограничен блеклыми или «плоскими» цветами — он вполне способен передавать насыщенные оттенки, если техника и софт это позволяют.

HDR изначально же ориентирован на Rec.2020 — широкое цветовое пространство, охватывающее до 75% видимого спектра. На практике же, большинство современных мониторов приближаются к охвату DCI-P3, промежуточному стандарту, популярному в киноиндустрии.

Важно: HDR как технология сам по себе не расширяет охват — он просто использует его, если дисплей это позволяет. Многие "HDR-мониторы" всё ещё имеют узкий охват и полностью не раскрывают потенциал HDR-контента.

Динамический диапазон: детали в тенях и светах

Основная идея HDR — сохранить больше информации одновременно и в тёмных, и в ярких участках изображения. Это особенно критично для сцен с контрастным освещением: закат, ночь с огнями города, свет сквозь окно в тёмной комнате и т.п.

Где SDR "выбивает" свет (плоское белое пятно) или теряет детали в тенях (слишком тёмно), HDR отображает нюансы — текстуру облаков в бликах, детали в складках чёрной ткани и т.д.

Почему HDR выглядит «реалистичнее»: немного психофизики

Восприятие изображения — это не просто вопрос цифр, а то, как наш мозг интерпретирует свет, цвет и контраст.

HDR работает с повышенной пиковой яркостью (до 1000 кд/м2 и выше), что делает изображения не просто ярче, а объёмнее. Особенно это ощущается в динамических сценах: например, когда камера выходит из тени на солнечную улицу — в HDR это выглядит как настоящий "всплеск света", приближённый к тому, как это ощущается в жизни.

Мозг интерпретирует такие резкие переходы как глубину, реализм и даже "тактильность". Особенно сильно этот эффект проявляется при наличии высокой контрастности в кадре: например, свеча в темноте или солнечный свет, бьющий сквозь листву.

Часть 2. HDR-стандарты и их особенности

HDR — это не один стандарт, а целое семейство форматов, каждый из которых определяет, как обрабатываются яркость, цвет и метаданные в видео. Эти стандарты различаются по сложности реализации, поддержке в оборудовании и контенте, а главное — по качеству итогового изображения.

В данном случае, метаданные — это служебная информация, которая описывает, как должен отображаться видеосигнал: например, насколько яркой должна быть сцена, какой цветовой охват используется, или как корректно отобразить тени и свет.

Метаданные бывают двух типов: статические — коррекции одинаковы для всего видео или фильма (например, как в HDR10); динамические — корректировки могут меняться от сцены к сцене или даже покадрово (как в HDR10+ или Dolby Vision), обеспечивая более точную передачу задумки автора.

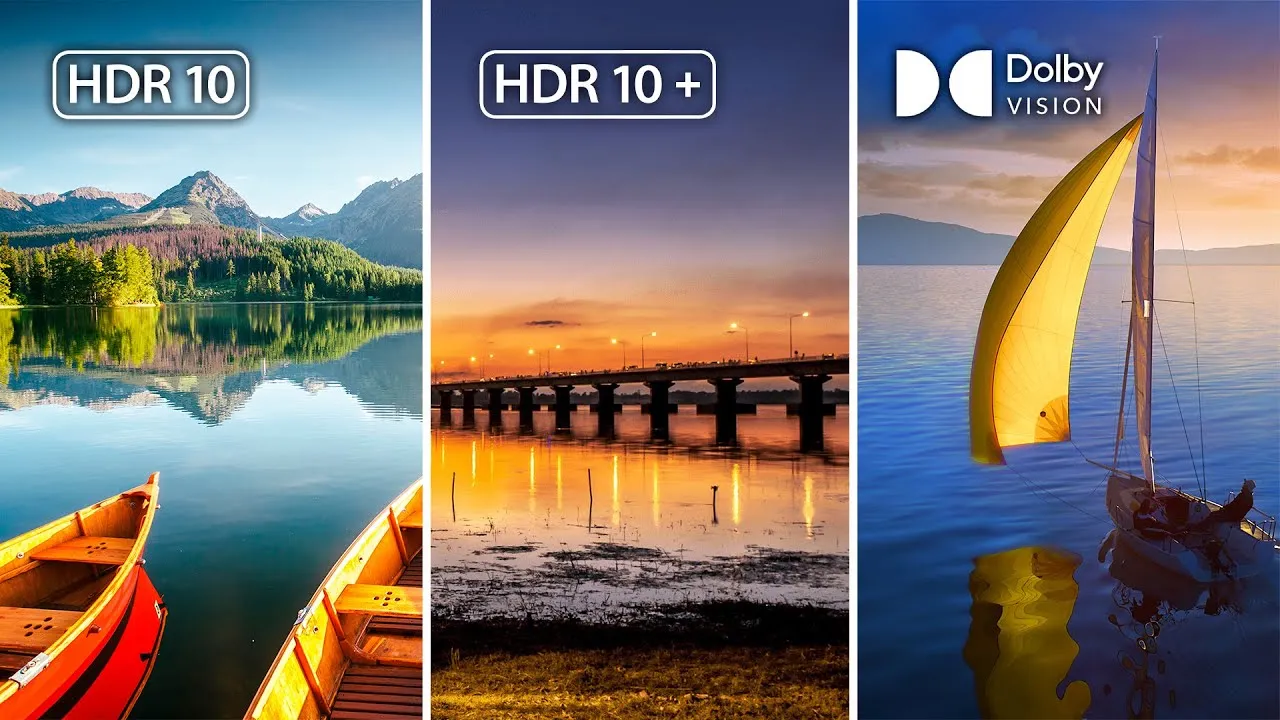

HDR10 — базовый и самый массовый

HDR10 — это открытый, повсеместно поддерживаемый стандарт и своего рода "точка входа" в HDR. Он использует:

-

10-битную глубину цвета

-

Цветовое пространство Rec.2020 (но может использовать более узкие - типа DCI-P3)

-

Статические метаданные (SMPTE ST 2086), которые описывают параметры яркости и цветовой гаммы один раз для всего видео.

Это означает, что сцены с разной яркостью обрабатываются по одной и той же схеме, без подстройки под конкретный момент. Несмотря на это ограничение, HDR10 остаётся самым распространённым форматом — от стримингов до Blu-ray.

Важно: Многие мониторы маркируются как “HDR10”, но при этом не достигают нужной пиковой яркости или не имеют расширенного цветового охвата. Это маркетинговая галочка, а не гарантия качества изображения.

HDR10+ — улучшенный вариант с динамическими метаданными

Разработанный Samsung и Amazon, HDR10+ сохраняет базу HDR10, но добавляет динамические метаданные, которые могут меняться кадр за кадром или сцена за сценой. Это позволяет более точно управлять яркостью и контрастом в зависимости от содержания кадра.

Дополнительные вариации стандарта:

-

HDR10+ Adaptive — адаптация изображения к условиям окружающего освещения (используется, например, в ТВ);

-

HDR10+ Gaming — адаптированная версия для игровых приложений, с минимальной задержкой и поддержкой переменной частоты кадров;

-

HDR10+ Pro — используется в некоторых профессиональных решениях, чаще всего маркетинговый термин.

HDR10+ также остаётся открытым, но не столь широко распространён, как HDR10, и поддерживается в основном устройствами от Samsung, Panasonic и некоторых других производителей.

Dolby Vision — премиальное решение

Dolby Vision считается самым продвинутым HDR-стандартом, разработанным Dolby Laboratories. Он предлагает:

-

Динамические метаданные

-

Поддержку до 12-битной глубины цвета

-

Цветовое пространство Rec.2020

-

Повышенные требования к пиковой яркости и точности отображения

Dolby Vision — закрытый стандарт, требующий лицензирования. Тем не менее, он получил широкую поддержку среди производителей ТВ, стриминговых сервисов (Netflix, Disney+) и даже игровых платформ (Xbox Series X/S поддерживает его в играх).

Для отображения полного потенциала Dolby Vision требуется совместимость не только на уровне дисплея, но и на уровне источника сигнала (плеер, ОС, контент) и цепочки передачи (например, HDMI 2.1 с поддержкой DV).

HLG (Hybrid Log-Gamma) — HDR для телевещания

HLG — совместный проект BBC и NHK, ориентированный на совместимость с SDR и упрощённую передачу HDR-сигнала в прямом эфире. Он не использует метаданные вовсе: кривая передачи яркости построена так, чтобы быть читаемой как SDR на обычных устройствах и как HDR — на совместимых.

HLG:

-

Поддерживается в стандартах вещания (DVB, ATSC 3.0)

-

Используется в телевизионных трансляциях 4K HDR

-

Реже встречается в мониторах, но активно поддерживается в современных ТВ

Сравнительная таблица HDR-стандартов

Ключевой тезис

Поддержка HDR-стандарта ≠ качественная реализация HDR.

Монитор может "поддерживать HDR10", но при этом:

-

иметь пиковую яркость лишь 300 кд/м2 (вместо требуемых 600–1000);

-

не обладать локальным затемнением;

-

иметь ограниченный цветовой охват (sRGB).

Вывод: Чтобы HDR действительно работал и впечатлял, важна не только поддержка стандарта, но и уровень аппаратной реализации — об этом пойдёт речь в следующей части статьи.

Часть 3. Сертификации и маркетинг

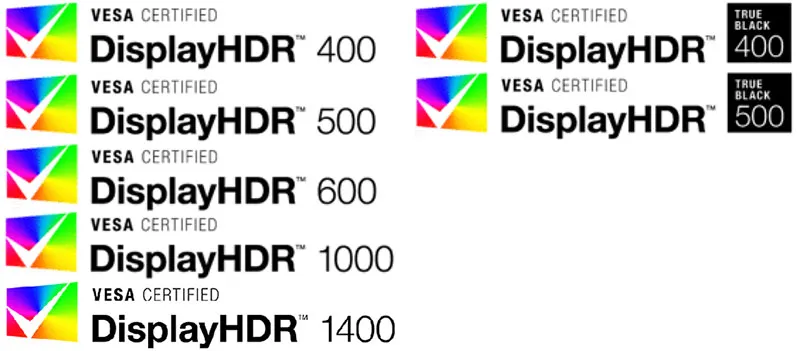

VESA DisplayHDR: попытка стандартизировать хаос

Ассоциация VESA (Video Electronics Standards Association) создала стандарт DisplayHDR как попытку навести порядок в хаотичной HDR-терминологии. Цель — дать потребителю понятное обозначение уровня HDR-поддержки на мониторах и экранах ноутбуков.

Каждому уровню DisplayHDR соответствует определённый минимум по яркости, контрасту, цветовому охвату и глубине цвета.

Основные уровни DisplayHDR для LCD:

-

DisplayHDR 400 — базовый уровень, минимальная пиковая яркость 400 кд/м2, 8-битный цвет (часто с FRC), без обязательного локального затемнения;

-

DisplayHDR 600 — яркость до 600 кд/м2, требование к локальному затемнению (хотя и в очень ограниченной форме), расширенный цветовой охват;

-

DisplayHDR 1000 — яркость 1000 кд/м2, улучшенное локальное затемнение, 10 бит, высокий контраст;

-

DisplayHDR 1400 — для профессиональных мониторов, пиковая яркость 1400 кд/м2, расширенные требования к охвату и контрасту.

Для OLED и Mini-LED дисплеев VESA ввела отдельные категории:

DisplayHDR True Black 400 / 500 / 600 — акцент на низкой яркости чёрного (менее 0.0005 кд/м2) и высокой контрастности, с типичной пиковой яркостью в районе 400–600 кд/м2.

Почему DisplayHDR 400 — это почти не HDR

Многие современные мониторы заявлены как “HDR” лишь потому, что соответствуют DisplayHDR 400 — но на практике это почти не HDR вообще:

-

Пиковая яркость в 400 кд/м2 — чуть выше, чем у качественного SDR-дисплея (а в некоторых случаях даже ниже);

-

Отсутствует локальное затемнение — теряется основной визуальный эффект HDR — резкий контраст между яркими и тёмными участками;

-

Часто используется 8-битная панель с FRC (имитацией 10 бит);

-

Цветовой охват обычно ограничен sRGB или чуть шире.

DisplayHDR 400 не требует настоящей HDR-обработки и служит скорее маркетинговой "наклейкой", чем технической гарантией качества.

DisplayHDR 600: формально лучше, по факту – компромисс

DisplayHDR 600 уже требует: минимум 600 кд/м2 пиковой яркости, расширенный цветовой охват (обычно ближе к DCI-P3), какое-то локальное затемнение (edge-lit или псевдо-зональное, с делением на небольшое количество (8-12 или чуть больше) зон подсветки при активном HDR).

Реальное качество HDR всё ещё сильно ограничено, особенно без полноценной многозонной подсветки (Full-Array Local Dimming или Mini-LED). Часто эффект HDR выглядит слишком резким, неравномерным, с засветами и потерей детализации.

HDR с подсветкой edge-lit (по краям) — это больше имитация, чем настоящее HDR. Без точного управления светом нельзя добиться глубины и контраста, ради которых и задумывалось HDR.

Почему большинство мониторов с надписью «HDR» не соответствуют ожиданиям

Многие дисплеи, особенно в бюджетном сегменте, технически не способны реализовать полноценный HDR, несмотря на маркетинговые логотипы.

Основные ограничения:

-

IPS-панели — обладают ограниченной контрастностью (1000:1), что затрудняет отображение глубоких теней и бликов, особенно без локального затемнения;

-

VA-панели — лучше с контрастом, но часто страдают от неравномерной подсветки и медленного отклика в тёмных сценах, а также отличаются гораздо худшими углами обзора чем IPS;

-

OLED — идеальны по контрасту и чёрному, но могут ограничиваться пиковой яркостью при полном заполнении экрана (Full-White, 100% APL). Однако это не проблема при типичном просмотре кино в затемнённом помещении — именно на это и ориентируются производители.

В результате многие "HDR-мониторы" демонстрируют картинку, лишь формально отличающуюся от SDR, или даже хуже, если HDR-сигнал не обрабатывается корректно (например, теряются детали в светах или тени становятся чересчур тёмными).

HDR — технология, которая на практике должна улучшать изображение, делая его ярче, контрастнее и насыщеннее. Но реальный пользовательский опыт часто далёк от этой идеальной картинки, особенно на ПК.

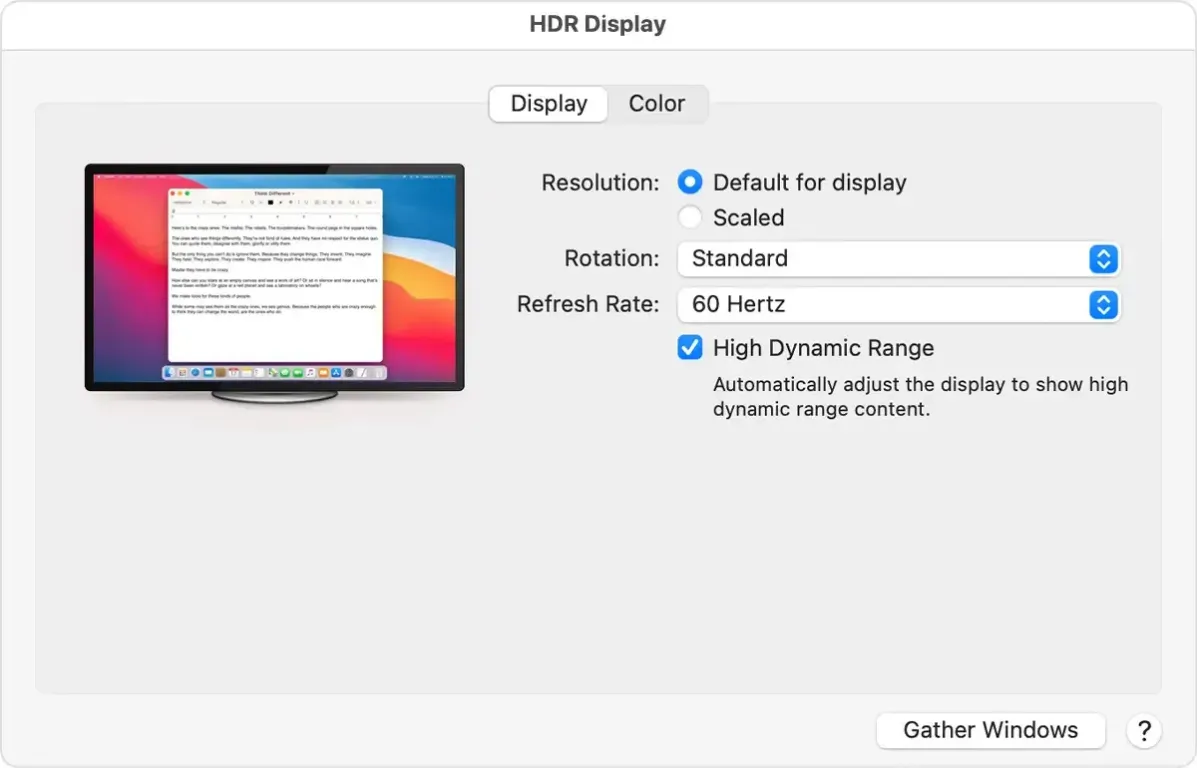

HDR в Windows: технически работает, но неудобно

Несмотря на то что Windows поддерживает HDR уже несколько поколений, реализация оставляет желать лучшего. При включении HDR изображение нередко становится выцветшим, особенно интерфейс самой системы и SDR-приложения. Работа с цветом усложняется: калибровка перестаёт действовать, поскольку активный HDR-режим отключает использование цветовых профилей (ICC), и ни одна утилита, включая профессиональные решения, не может это обойти. Пользователь вынужден выбирать — или корректный цвет, или HDR. Ситуация постепенно улучшается (как со стороны ОС - Auto HDR, так и конечных мониторов), но до идеала, в нашем представлении, должно пройти ещё пару лет.

Нередко приходится вручную переключать режим HDR в настройках, чтобы получить приемлемую картинку — скажем, выключить его для работы в Photoshop или в браузере, а затем снова включить для фильмов или игр. Это неудобно, сбивает поток работы и превращает HDR в постоянную возню с настройками.

macOS, Linux и консоли: кто как справляется

В экосистеме Apple всё значительно проще, но не всегда лучше. На MacBook Pro с Mini-LED-дисплеем или в связке с Pro Display XDR HDR работает прозрачно: система и приложения плавно переключаются между SDR и HDR, без пересветов, потери цвета или ручных манипуляций. Цветокоррекция учитывается даже в HDR-режиме, и вся система визуально выглядит так, как и должна.

Linux же пока отстаёт. Поддержка HDR находится в зачаточном состоянии — она появляется в некоторых окружениях вроде Wayland/KDE, драйверах NVIDIA и AMD, но стабильности нет. HDR-видео в браузере, игры, управление цветом — всё это требует ручных настроек, патчей и часто нестабильно работает даже на современных системах.

Игровые консоли, напротив, демонстрируют, как должен работать потребительский HDR. На PlayStation 5 и Xbox Series X/S HDR включается автоматически, если игра его поддерживает, а консоль сама на лету адаптирует картинку под конкретный экран. Это обеспечивает стабильное, яркое и предсказуемое изображение без вмешательства пользователя — именно так HDR задумывался изначально.

Видео, игры и графика: контрастные сценарии

В играх HDR может давать мощный эффект — бликующий свет, реалистичные закаты, глубокие тени — но всё зависит от качества реализации в конкретном проекте. Есть игры с отличным тонмаппингом (то процесс преобразования диапазона яркостей HDR к LDR диапазону, отображаемому устройством вывода) и точной калибровкой, а есть и те, где HDR делает картинку хуже, неестественно контрастной или «мыльной».

С видео ситуация надёжнее: сервисы вроде Netflix, Disney+ и YouTube выдают корректный HDR-поток, который качественно воспроизводится на ТВ или совместимом мониторе. Но даже здесь возможны нюансы — например, браузер должен поддерживать HDR, а система — правильно переключить режим. Blu-ray HDR-диски (особенно с Dolby Vision) демонстрируют наилучшее качество, но требуют полного соответствия по оборудованию и программному обеспечению.

Что касается фото и графики, HDR в этих областях пока не стал нормой. Форматы изображений с расширенным динамическим диапазоном существуют, но их поддержка ограничена, а необходимость — спорна. Просмотр HDR-фото на дисплеях с реальным HDR возможен, но массового перехода пока не произошло: профессиональная работа по-прежнему чаще ориентирована на sRGB и Rec.709.

Совместимость и ПО: вечный компромисс

Пожалуй, главное препятствие для комфортного использования HDR — это отсутствие единого подхода. Один и тот же монитор может по-разному вести себя в Windows, macOS и на приставке. Программы не синхронизированы с системными настройками, калибровка может не применяться, а контент — отображаться не так, как задумано. Всё это требует от пользователя не только знания теории, но и терпения.

В итоге HDR остаётся мощным, но нестабильным инструментом, работающим отлично только тогда, когда совпадают все условия: правильное устройство, подходящий стандарт, настроенное ПО — и немного удачи.

Часть 5. Советы по выбору HDR-монитора

HDR-монитор — это не просто логотип "HDR10" в описании. Это прежде всего аппаратная платформа, которая либо позволяет раскрыть потенциал HDR-контента, либо лишь имитирует его для галочки. Чтобы не переплачивать за яркую наклейку и не разочароваться, важно понимать, на что действительно стоит смотреть при выборе.

Что важно: реальные параметры, а не маркетинг

В первую очередь, не стоит опираться только на "поддержку HDR" — она означает лишь возможность принять HDR-сигнал, а не корректно его отобразить. Реально значимые параметры:

-

Пиковая яркость — чем выше, тем лучше. Для приемлемого HDR нужна хотя бы 600 кд/м2, а полноценный эффект раскрывается от 800–1000 кд/м2;

-

Контрастность — критически важна. Панели IPS с постоянным 1000:1 не могут показать глубокие тени без помощи подсветки. У VA контраст выше, но без локального затемнения всё равно недостаточен. Есть варианты IPS Black с заявленным контрастом 2000:1 и даже 3000:1, что приближает их к возможностям VA, но таких устройств на рынке не так уж и много;

-

Подсветка и локальное затемнение — если вы берёте любой подходящий под ваши задачи LCD-монитор, наличие Mini-LED с большим числом зон — главное условие. И здесь важно не только «сколько зон», но и как они управляются: качественная программная реализация (на уровне прошивки) может значительно улучшить восприятие. Сейчас же производители стараются улучшать микролинзы каждого Mini-LED светодиода, для более точного управления потоками яркости;

-

Цветовой охват — желательно не ниже 90–95% DCI-P3, иначе часть HDR-контента будет выглядеть блекло;

-

10-битная глубина цвета — позволяет отобразить более миллиарда оттенков и избежать постеризации;

При этом важно понимать: современные 8-битные панели с FRC (дизерингом) уже весьма близки по визуальному качеству к "настоящим" 10-битным. Для обычного зрителя разница незаметна вовсе.

-

Сертификация VESA DisplayHDR — только от DisplayHDR 600 и выше можно рассматривать всерьёз, и то с оговорками. Всё, что ниже — имитация HDR, не дающая визуальных преимуществ;

-

Отзывы и обзоры — ключевой ориентир. Только реальные тесты (яркость, локальное затемнение, засветы, поведение в Windows/играх) дают объективную картину.

Минимум, с которого начинается «приемлемый» HDR

Если говорить честно, настоящий HDR-опыт начинается с OLED. Даже недорогие модели обеспечивают идеальный чёрный и высокий субъективный контраст, что даёт максимальный эффект в кино и играх. У OLED есть ограничения по пиковой яркости при полной заливке, но для обычных условий просмотра (особенно в тёмной комнате) этого более чем достаточно.

Если OLED недоступен, то худший допустимый вариант — это качественная LCD-модель с Mini-LED подсветкой и максимально возможным числом зон в пределах вашего бюджета. Чем больше зон, тем точнее работает локальное затемнение, и тем меньше ореолов вокруг ярких объектов на тёмном фоне. Также стоит обращать внимание на прошивку: некоторые мониторы умеют динамически адаптировать подсветку под сцену гораздо лучше других, даже при равных характеристиках.

Модели на обычной edge-lit подсветке, пусть даже с "DisplayHDR 600", в лучшем случае дают полу-HDR, а чаще всего просто ухудшают восприятие контента.

Стоит ли переплачивать за HDR?

Зависит от сценария. Если вы в основном работаете с текстом, кодом или вебом — HDR не даст вам ничего полезного. Это избыточная опция, которую вы отключите в первый же день.

Если смотрите фильмы, особенно в тёмной комнате — да, HDR оправдан. Но только если у дисплея действительно хороший контраст, поддержка Dolby Vision или хотя бы точный HDR10, и желательно — OLED. Если играете в современные игры — HDR может быть мощным инструментом визуального погружения, особенно в играх с грамотной реализацией. В этом случае — да, стоит.

Но переплачивать стоит только за те технологии, которые действительно реализованы. Покупать "HDR Ready" IPS-панель с 400 кд/м2 и без локального затемнения — это выброс денег. Лучше чуть доплатить и получить пусть не идеальный, но реально работающий HDR-дисплей.

Заключение

HDR — это не просто логотип в спецификациях монитора и не "волшебная кнопка улучшения картинки". Это целый комплекс аппаратных и программных решений, работающих только в связке: от подсветки и панели до алгоритмов отображения и формата контента. Реализовать HDR по-настоящему — задача далеко не тривиальная. Она требует:

-

качественного дисплея с высокой пиковой яркостью, хорошим контролем контраста и широким цветовым охватом;

-

правильно подготовленного HDR-контента (будь то фильм, игра или видео на YouTube);

-

и, желательно, просмотра в условиях контролируемого внешнего освещения — в полумраке или тёмной комнате, как советуют и производители, и независимые тестеры.

Только при соблюдении всех этих условий HDR может раскрыться и действительно произвести впечатление. Хотя фраза "один из самых заметных визуальных апгрейдов последних лет" звучит слишком амбициозно, нельзя отрицать: в хорошо реализованном виде HDR способен приятно удивить — особенно в фильмах и играх, где работа со светом и контрастом является частью художественного замысла.

Однако стоит быть честными: HDR — это по-прежнему нишевая технология, уместная прежде всего в мультимедийных сценариях. Для повседневной работы, серфинга, офисных задач и даже большинства профессиональных кейсов она попросту не нужна. Это не новый стандарт "по умолчанию", а скорее опциональное улучшение, которое может дать эффект — а может и разочаровать, если попасть в ловушку маркетинга.

Поэтому, выбирая монитор с HDR, лучше отбросить рекламные лозунги и сосредоточиться на реальных технических параметрах, проверенных тестами и опытом пользователей. И помнить главное: если HDR и делает картинку "лучше", то только тогда, когда всё вокруг этого работает как надо. А такое, к сожалению, случается не так уж часто.

Будем реалистами — и пусть HDR не морочит нам голову.

КАТАЛОГ МОНИТОРОВ

Получи бесплатно чистящее средство

при покупке данного монитора

Получи бесплатно чистящее средство

при покупке данного монитора

Получи бесплатно чистящее средство

при покупке данного монитора